说到人工智能,除了某些很酷的前沿应用外,其实对于这个话题我们经常会想到「假」这件事,用人工智能完成的造假除了一些灰产之外,更成为了一种娱乐方式,其中最有名的可能就是 AI 换脸的了,这种换头术至今还在 B 站大肆流行着。

相反的,AI 应用在现实中带来的「真」变化可谓少之又少。不过最近美国麻省理工学院的研究人员发现了一种与「造假」相反的 AI 研究,这种研究反而需要 AI 来点「真」的东西,准确的说是针织的东西。

这项研究让人有点出人意料,谁能想到机器学习的能力会用在复制针织品身上呢?

首先我们要回答一个问题:为什么不能直接交给 Shima Seiki 这样的自动针织机进行「复制」或「创造」。

关于这件事如果你拿出几件自己的针织衫看一下可能就知道答案了,在很多的针织品中实际上表面并不是完全平整的,商家为了满足个性化需求通常会在针织品上再做出不同的针织图案,而这些图案的织法和其它地方是不同的,也正是因为了有了这部分「创意」存在,死板的自动针织机就无法完成这项任务了。

为此研究人员中有了一项新的想法,要使用自动针织机需要大量的专业知识为其「编程」,所以他们想出了用一种方便理解的软件去简化这个流程,即便是没有相关经验的人也能够上传自己的作品。

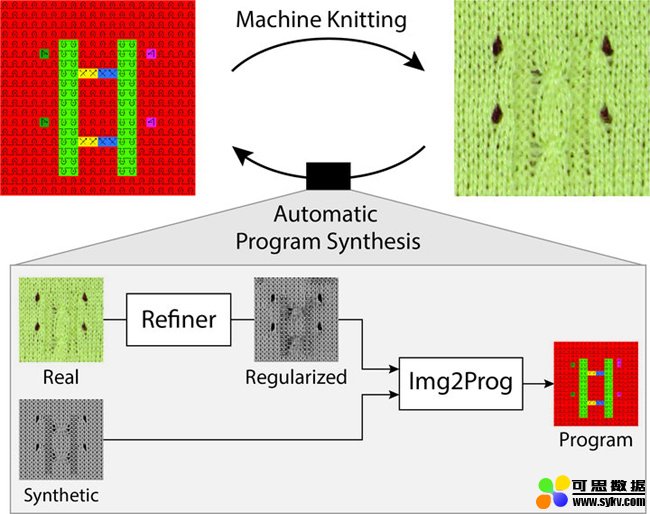

但即便如此这仍然需要大量手动去设置指定图案的织法,而这就是机器学习有趣的地方,通过神经逆编织网络,它可以通过算法去学习针织手法。然后将真实的织法与设计图案相结合,并转换成自动针织机能够识别的指令。你可以将这种模式成为「计算编织」。

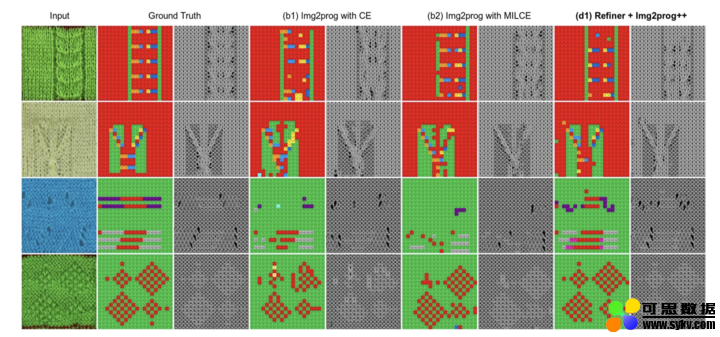

不过就如包含补充材料的论文中详细描述的那样,神经网络必须计算两个不同的东西:它必须首先计算所展示的服装的理想表现形式,然后再计算所涉及的针脚。

▲ 图片来自:zdnet

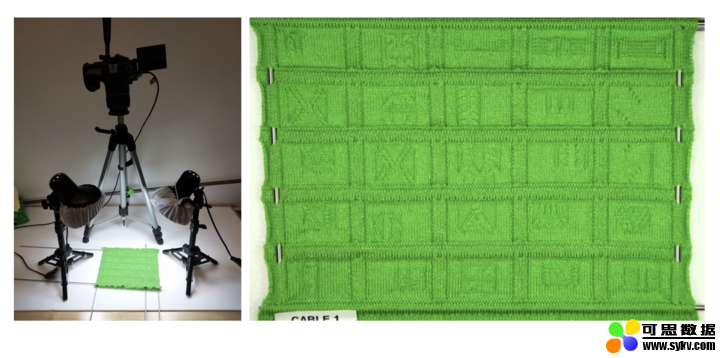

首先,神经网络被送入两种样本,即作者从头开始编织然后拍摄的针织服装真实照片,然后由他们的软件合成服装图像。合成之后的图片会比真实世界的照片更简洁。

为了将设计图案与真实图案进行融合,AI 其中起到了很大作用。

然后进行 IMG2PROG,就是将图案转换为指令,支持将这种像「混合图层」之后的合称图案导出指令,为了简化过程,程序开发者定义了 17 条基本针织手法的指令标签,而合成图案上会带有这些标签,再通过神经网络与这些标签进行「交叉熵」优化,最后完成机器统计,再输入自动针织机,大功告成。

这就是 AI 有趣的地方,它是一个人与机器之间沟通的桥梁,理解人类的自然语言、想法已经创造力,并将其转换成机器与数字世界的语言。

在未来,很多事你未必懂得具体的实现过程,但只要你有足够的想象力,AI 就能帮助你将其变成现实。